Escrito por Marina Brocca

Índice

- La historia que lo ilustra todo: un experimento real contado en LinkedIn

- Estado real del Reglamento de IA

- Los “chernobiles digitales” que ya han pasado (y que justifican este protocolo)

- Protocolo IA: las 7 fases obligatorias antes de automatizar con IA

- FASE 1 – Clasificación del caso de uso

- FASE 2 – Evaluación de datos y arquitectura (DPIA + IA DPIA)

- FASE 3 – Blindaje contractual (Legal Pack)

- FASE 4 – Transparencia obligatoria (YA aplicable)

- FASE 5 – Supervisión humana y safeguards técnicos

- FASE 6 – Evaluación continua trimestral

- FASE 7 – Gobernanza interna de la empresa

- Mi recomendación de herramientas compliance

- Checklist: Las 7 fases obligatorias antes de automatizar con IA

- Conclusión: La IA no te va a sustituir… pero sí te puede arruinar si no hay gobernanza

- Para el artículo de hoy contamos con la colaboración de Marina Brocca, especialista en RGPD y marketing legal. La experta ha preparado esta completa guía para integrar de forma segura la IA en empresas y departamentos de marketing. Sin riesgos legales, sin problemas reputacionales y sin “Chernobiles digitales”.

¿Cuántos contenidos sobre automatizaciones e integraciones con IA has leído o escuchado ya? Estoy segura de que una cantidad ingente, como yo. Pero hay un detalle: ninguno te ha explicado cómo hacerlo sin riesgos, sin fisuras y sin sanciones —y créeme, esas sanciones llegarán y serán escandalosas.

Si tu empresa ya usa chatbots, copy generado por IA, personalización avanzada, ajuste inteligente de precios, campañas automáticas o integraciones complejas en n8n, Make o Zapier… esta guía no es una opción: es tu único blindaje legal y estratégico.

Hoy, la inteligencia artificial puede generar márgenes de doble dígito para cualquier empresa, pero también destruir su reputación en menos de 7 segundos. La diferencia entre una empresa que factura 5.000 € y otra que cobra 12.000 € por su gobernanza se reduce a una palabra: blindaje.

Esta guía no es un simple post. Es un protocolo profesional de alto valor, listo para implementar en tu empresa. Un marco que puedes establecer como estándar de excelencia y por el que puedes cobrar una AI Responsibility Fee de entre 18.000 y 45.000 €.

La historia que lo ilustra todo: un experimento real contado en LinkedIn

Hace poco, un profesional del sector compartió en LinkedIn un experimento muy revelador. Había configurado un flujo aparentemente sencillo en n8n: a partir de datos de un CRM (nombre, email, ubicación, empresa…), un agente de IA generaba un email personalizado para cada contacto. La idea era buena: que cada persona sintiera un trato personalizado, sin invertir horas revisando cientos de mensajes.

Lanzó el flujo: 750 correos en cola, 40 minutos de ejecución, todo parecía perfecto.

Hasta que empezaron a llegar las respuestas.

En menos del 2 % de los casos, la IA alucinó: inventó información personal del destinatario que jamás figuraba en el CRM. Cosas pequeñas pero completamente falsas: ciudades de origen, cargos inexistentes, aficiones aleatorias… personalizaciones que parecían humanas, pero no lo eran. “Pequeños delirios”, lo llamó.

El profesional lo descubrió por las respuestas de los propios destinatarios —algunas con humor, otras con extrañeza— señalando los “toques creativos” que la automatización había decidido añadir por su cuenta.

La reflexión que compartió fue contundente: “Esta anécdota me dejó pensando en los riesgos reales de automatizar con IA sin guardarraíles acordes al riesgo del proceso”.

Estado real del Reglamento de IA

La regulación ya no es una promesa futura: está en vigor hoy mismo y afecta directamente cada acción que implementes con IA. Ignorarla ya no es una opción; cada decisión, automatización o integración debe contemplar su cumplimiento. Veamos cómo se traduce esto en obligaciones concretas, fechas clave y riesgos reales para tu empresa:

- Prohibidos. Desde el 2 de febrero de 2025: deepfakes no marcados, llevar a cabo scoring social o la manipulación subliminal.

- Modelos GPAI (OpenAI, Google, Anthropic, Meta): obligaciones de transparencia desde el 12 de agosto de 2025.

- Riesgo limitado (chatbots, contenido sintético): transparencia obligatoria YA.

- Alto riesgo: documentación obligatoria desde agosto de 2026 y plena aplicación en agosto de 2027.

- Sanciones: hasta 35 M€ o 7 % de facturación global. Ya hay inspecciones en España, Italia y Francia.

España ya tiene inspecciones abiertas. La ley es real y se está ejecutando.

Si quieres un resumen del nuevo reglamento, te recomiendo este post que he escrito de forma muy clara y didáctica.

Los “chernobiles digitales” que ya han pasado (y que justifican este protocolo)

Google Gemini 2024–2025

Google suspendió la función de su IA Gemini para generar imágenes de personas después de que usuarios denunciaron que generaba representaciones históricamente incorrectas, como nazis chinos o vikingos negros, por sobrerrepresentar a minorías étnicas.

El resultado de la IA es tu responsabilidad.

Air Canada 2024–2025

Su chatbot inventó una política de reembolso. El tribunal la obligó a pagar.

Lección: eres legalmente responsable de las alucinaciones de tu chatbot.

Willy Wonka Glasgow 2024

Promocionaron un evento con imágenes generadas por IA que no existían. Denuncias masivas.

El uso engañoso de la IA genera demandas e impacta en la reputación de la empresa.

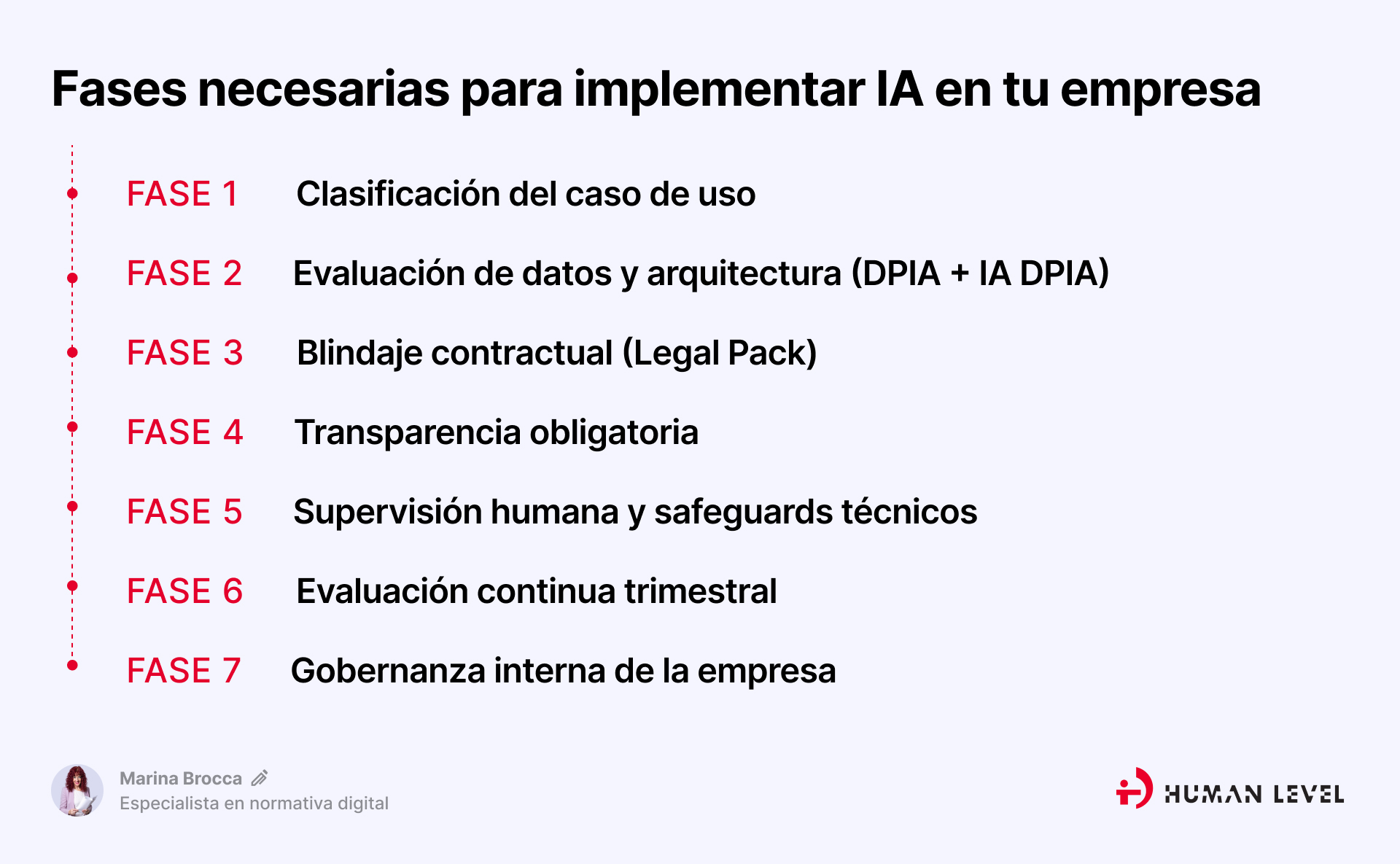

Protocolo IA: las 7 fases obligatorias antes de automatizar con IA

Olvídate de “vamos probando” o “ya lo iremos ajustando sobre la marcha”.

Eso es lo que hacen las empresas que acaban en titulares de prensa o en los expedientes sancionadores de la AEPD.

Las empresas que facturan más, retienen clientes enterprise y duermen tranquilas siguen siempre estas siete fases, en este orden exacto.

No son opcionales. Son tu blindaje legal, tu ventaja competitiva y tu nueva fuente de margen.

Si te saltas aunque sea una sola fase, estás jugando a la ruleta rusa con la reputación y el dinero de tu empresa o la de tu cliente.

Aquí van las 7 fases, explicadas de forma cristalina y con todo lo que necesitas para implementarlas mañana mismo:

FASE 1 – Clasificación del caso de uso

Antes de implementar cualquier IA, clasifica el uso según el riesgo legal y de derechos de los usuarios:

- Generación de contenido: riesgo mínimo/limitado. Exige etiquetar claramente “Generado por IA”.

- Chatbots de atención o captación de leads: riesgo limitado. Es obligatorio informar al usuario de que interactúa con una IA y mantener registros de la conversación.

- Segmentación de usuarios con datos sensibles : alto riesgo. Requiere una evaluación de impacto de protección de datos (DPIA) y registro en la UE a partir de 2026.

- Pricing dinámico o algoritmos que afectan a la economía del usuario : alto riesgo. Cualquier decisión que afecte a sus derechos económicos exige controles estrictos.

- Contenido SEO masivo: riesgo limitado, aunque podría ser alto si impacta a los usuarios. Requiere supervisión humana.

- Voz sintética o deepfakes: prohibido salvo que haya marcado visible y consentimiento explícito.

- Automatizaciones con n8n u otros sistemas de orquestación: riesgo mínimo/limitado si solo ejecutan tareas técnicas. Sin embargo, pasan a riesgo alto cuando desencadenan acciones que toman decisiones automatizadas con efectos legales o económicos sobre el usuario.

FASE 2 – Evaluación de datos y arquitectura (DPIA + IA DPIA)

(El momento en el que decides si el proyecto es legal o es una bomba de relojería)

¿Por qué tienes que responder estas 6 preguntas POR ESCRITO antes de tocar ni un solo dato de tus clientes?

Porque si mañana la AEPD o un cliente te pregunta “¿dónde están mis datos y quién los ha visto?”, la respuesta “eh… creo que está todo bien” te cuesta entre 20.000 € y 35 millones € de multa y, por supuesto, la relación con el cliente rota para siempre.

Las 6 preguntas clave

1. ¿Qué datos exactos van a entrar en la IA?

Lista literal: nombre, email, historial de compras, ubicación, ingresos, etc.

Si no lo sabes con precisión, ya estás incumpliendo el principio de minimización del RGPD.

2. ¿Son realmente necesarios para lo que queremos hacer?

Si puedes hacer el copy o la segmentación sin el DNI o el salario, quítalos.

Evitas que se te clasifique como alto riesgo y reduces la posible multa.

3. ¿Se transfieren fuera del Espacio Económico Europeo (EEE)?

EE.UU., India, Singapur, etc. obviamente se sitúan fuera del EEE.

Sí: necesitas medidas extra (ver pregunta 7).

4. ¿El proveedor usa esos datos para entrenar sus modelos?

Respuesta rápida: OpenAI (plan gratis y normal) SÍ por defecto.

OpenAI Enterprise, Claude Enterprise, Gemini Enterprise, Mistral, Groq, Cohere: NO.

Si el proveedor entrena con datos del cliente sin permiso, supone una violación grave del RGPD + AI Act.

5. ¿Existe DPA (contrato de encargado del tratamiento) firmado con TODOS los subprocesadores?

No vale solo con OpenAI. También con Pinecone, Supabase, ElevenLabs, etc.

Sin DPA: recuerda que hay responsabilidad solidaria para ti y para el cliente.

6. ¿Los datos sensibles se borran automáticamente después de usarlos?

Ejemplo: el prompt con datos personales debe desaparecer en <30 días (ideal <24 h).

La mayoría de planes Enterprise lo hacen por defecto.

Cómo documentarlo en 5 minutos

Crea una tabla de una página por proyecto en Notion, Google Docs o Excel y rellénala así:

1. ¿Qué datos exactos se usan?

- Respuesta: Email, historial de compras, ubicación

- Documento que lo prueba: Captura del prompt / código

2. ¿Son necesarios para la finalidad?

- Respuesta: No, se pueden anonimizar

- Documento que lo prueba: Justificación escrita

3. ¿Hay transferencia fuera del EEE?

- Respuesta: Sí (EE.UU.)

- Documento que lo prueba: Lista de proveedores

4. ¿Se entrenan modelos con estos datos?

- Respuesta: No (Modelo: Claude Enterprise)

- Documento que lo prueba: Captura del contrato o web

5. ¿Se ha firmado un DPA con todos los proveedores?

- Respuesta: Sí, fecha: 12/03/2025

- Documento que lo prueba: Enlace al PDF firmado

6. ¿Existe borrado automático de los datos?

- Respuesta: Sí, en 24 horas

- Documento que lo prueba: Configuración del proveedor

7. ¿Se ha realizado un TIA (Transfer Impact Assessment)?

- Respuesta: Sí, fecha: 15/03/2025

- Documento que lo prueba: PDF del TIA

Guarda esa tabla firmada por el Responsable de IA y el cliente.

Eso es tu seguro de vida y la manera más sencilla y eficaz de cubrirte por si sale algo mal.

También puedes usar una herramienta automática que haga el 90 % por ti. Con DataGrail, Ethyca u Osano, conectas tus herramientas y en 24 horas te genera el mapa completo de datos más las respuestas a las 7 preguntas.

Resultado: en una tarde tienes el documento perfecto y legal para cualquier cliente enterprise.

FASE 3 – Blindaje contractual (Legal Pack)

Todo proveedor de IA debe firmar:

Contrato de encargo de tratamiento o DPA RGPD completo.

Addendum específico IA, incluyendo:

- Prohibición absoluta de usar datos del cliente para entrenar modelos.

- Notificación de brechas en menos de 24h.

- Responsabilidad solidaria ante daños.

- Derecho de auditoría anual.

- Model Card (un documento estandarizado que describe cómo funciona un modelo de IA concreto, sus limitaciones, sesgos, rendimiento y casos de uso recomendados) o System Card del modelo (una versión más amplia y detallada que la Model Card; incluye no solo el modelo, sino todo el sistema completo que lo rodea: infraestructura, safeguards, políticas de moderación, etc.) Google lo usa para Gemini y es el estándar más exigente hoy.

- Compromiso escrito de cumplimiento del AI Act.

FASE 4 – Transparencia obligatoria (YA aplicable)

No es opcional. No es “buena práctica”. Es la ley.

Si no avisas al usuario de que está interactuando con una IA, estás incumpliendo el Reglamento de IA y te expones directamente a multas de hasta 15 millones de € o el 3 % de la facturación global. Y lo peor: si se trata de una implementación que has hecho para otra empresa, la multa la paga el cliente final (el responsable del tratamiento), pero el cliente te la va a reclamar a ti con intereses porque fuiste tú quien propuso e implementó la solución.

Ejemplos concretos y exactos que tienes que aplicar:

Email marketing / newsletters / automatizaciones:

Texto obligatorio (en el asunto o en el primer párrafo/footer bien visible):

“Este mensaje ha sido redactado con ayuda de inteligencia artificial y revisado por nuestro equipo.”

Chatbots y asistentes en web / WhatsApp / Instagram

El primer mensaje que vea el usuario tiene que decirlo claramente:

“Hola, soy un asistente de inteligencia artificial. Puedo equivocarme. Todo lo que te diga será revisado por un humano si lo necesitas.”

Si no pones esto, estás incumpliendo el artículo 52.1 del AI Act desde ya (todavía no he encontrado ejemplos de webs que lo estén haciendo).

Imágenes y vídeos generados o retocados con IA

Tienes dos opciones legales (elige una, pero nunca ninguna):

- Poner una marca de agua (watermark) visible (esquina inferior derecha o izquierda): “Imagen generada por IA” o el símbolo “IA”.

- Usar metadatos C2PA (el estándar oficial que ya usan Adobe, Leica, Microsoft, Google, etc.)

Esto incrusta la información en el archivo y no se puede borrar.

Ejemplo: cualquier carrusel de Instagram con imágenes de Midjourney debe incluir una watermark obligatoria.

Anuncios pagados en Meta, Google Ads, TikTok Ads, LinkedIn Ads

Desde enero de 2025, todas las plataformas obligan a marcar el anuncio si contiene:

- Imagen sintética.

- Vídeo con deepfake o voz sintética.

- Texto generado por IA (en algunos casos).

En Meta y Google tienes que hacer clic en la casilla: “Este anuncio contiene contenido alterado o generado por inteligencia artificial”.

Si necesitas plantillas para adaptar políticas de privacidad, cláusulas para chatbots, campañas de lanzamiento, promociones con imágenes IA, etc. he desarrollado KITS de plantillas de adaptación web para IA.

FASE 5 – Supervisión humana y safeguards técnicos

(La fase que evita que tu empresa sea el próximo caso viral por la IA diciendo tonterías o haciendo daño).

Explicación clara, sin tecnicismos y como si se lo contaras a un cliente o superior que no sabe de tecnología: esta fase es la red de seguridad.

Aquí pones controles reales para que la IA nunca actúe sola y de forma descontrolada.

1. Despliegue gradual (no lo sueltes todo de golpe).

Nunca actives la IA para todos los usuarios el primer día. Hazlo en cuatro pasos seguros: primero al 0,5 % de los usuarios (casi nadie lo nota, pero tú ves si algo falla).

Si va bien tras 3-7 días, pasas al 5 %.

Si sigue perfecto, amplíalo al 25 %.

Solo cuando lleves varias semanas sin problemas, desplégala para todos.

Recuerda el ejemplo que puse al principio: siempre debe haber una persona revisando lo importante. La IA no tiene criterio. Tú sí.

Revisión humana 100 % obligatoria en:

- Todo texto que se publique o envíe al cliente final (anuncios, emails, posts, landing).

- Cualquier segmentación o campaña que mueva más de 50.000 € de presupuesto.

- Todo precio que cambie automáticamente (pricing dinámico).

- Cualquier respuesta delicada del chatbot (devoluciones, quejas, datos personales).

Regla fácil de recordar:

“Si puede costar dinero, reputación o una demanda, un humano lo mira antes de que salga”.

2. Kill-switch: el botón rojo de emergencia.

Dos tipos, los dos imprescindibles:

- Kill-switch manual: un botón físico o en un dashboard que detiene TODO el sistema de IA en 3 segundos. Tú o el cliente lo pulsáis y se acabó.

- Kill-switch automático: la herramienta bloquea autónomamente cualquier respuesta si el modelo dice “no estoy seguro” o la confianza es menor al 85 %.

Ejemplo: la IA va a enviar un email diciendo “tu pedido llega mañana”, pero en realidad llegaría en 15 días. El sistema se bloquea automáticamente y pasa a revisión humana.

3. Logs de todo lo que hace la IA (guardar huella durante 24 meses)

Tienes que poder demostrar qué preguntó la empresa, qué respondió la IA y qué se envió al cliente final. Para eso usas una herramienta sencilla (las recomiendo al final del post)

Estas herramientas guardan automáticamente todo y te permiten buscar en segundos: “¿Qué le dijo la IA al cliente X el día 12 de marzo?”. Es la manera de acreditar diligencia y evidencias si hay una denuncia o inspección de la AEPD.

FASE 6 – Evaluación continua trimestral

Cada 90 días, auditar la IA:

- Revisar 100 outputs aleatorios.

- Test de sesgos (Holistic AI o Fairlearn).

- Elaborar informe ejecutivo para cliente.

- Monitorizar drift del modelo (cambios en comportamiento del algoritmo).

FASE 7 – Gobernanza interna de la empresa

(El activo intangible que convierte el cumplimiento en una máquina de generar margen).

Esta es la fase que separa a las empresas que “usan IA” de las que ganan dinero protegiendo al cliente mientras usan IA. Sin gobernanza interna, todo lo anterior (clasificación, contratos, guardrails…) se derrumba en cuanto un junior copia-pega un prompt en ChatGPT con datos sensibles.

Los seis elementos obligatorios que toda empresa seria debería haber implementado antes del 31 diciembre de 2025:

Política Interna de Uso Responsable de IA (versión 2025)

1. Documento firmado por dirección. Incluye:

- Lista de modelos permitidos y prohibidos (ej. GPT-4o Enterprise sí, ChatGPT gratis NO).

- Regla de oro: “Ningún dato sensible sale de la empresa sin DPA + cláusula de no-entrenamiento”.

- Prohibición absoluta de subir datos sensibles a modelos públicos.

- Procedimiento para aprobar nuevos proveedores/herramientas IA.

- Sanciones internas (advertencia e incluso despido).

2. Registro Interno de Casos de Uso y Clasificación de Riesgo

- Una tabla viva (Notion, Airtable o Google Sheets) con una fila por proyecto/cliente: Cliente.

- Caso de uso (chatbot, copy IA, segmentación, etc.)

- Clasificación AI Act (mínimo/limitado/alto).

- Modelos usados.

- Fecha de última auditoría.

- Responsable del proyecto.

Esto es tu seguro de vida en caso de inspección de la AEPD o de una demanda.

3. Formación obligatoria anual (mínimo 8 horas certificadas)

Temario obligatorio 2025: RGPD + AI Act aplicado a marketing.

- Riesgos reales y casos de Chernobiles.

- Uso seguro de prompts y herramientas.

- Cómo detectar alucinaciones y sesgos.

- Protocolo de emergencia si la IA dice algo ilegal o tóxico.

- Certificación final con examen.

4. Nombramiento oficial de Responsable de IA (AI Officer)

No tiene que ser una persona nueva (puede ser el CTO, el DPO o un senior de operaciones), pero sí debe existir por escrito.

Funciones:

- Aprobar o vetar cualquier nueva herramienta IA.

- Revisar trimestralmente el Registro de Casos de Uso.

- Liderar el Comité IA.

- Ser el interlocutor con clientes en temas de cumplimiento.

5. Comité IA mensual (30–60 minutos)

- Obligatorio asistir: dirección + Responsable IA + legal/operaciones.

- Agenda fija: revisión de nuevos proyectos con IA.

- Incidentes del último mes.

- Actualización de proveedores y herramientas.

- Métricas de cumplimiento.

6. AI Responsibility Fee – El plus que dispara el margen

Las empresas que tienen estos 5 puntos anteriores implementados pueden (y deben) cobrar un sobrecoste del 15–25 % en cualquier proyecto que incluya IA. Cómo lo vendes al cliente (frase que convierte al 100 %):

“Por la implantación del Protocolo IA y la gobernanza completa de IA, aplicamos un AI Responsibility Fee del X %. Este sobrecoste cubre la clasificación de riesgos, blindaje contractual, supervisión humana, auditorías trimestrales y la tranquilidad de que nunca tendrá una multa o escándalo por nuestra IA.”

Resultado real de 2025 (datos de 27 empresas españolas y latinas que lo aplican): incremento de más del 18,4 % en su margen neto medio en proyectos con IA.

El cierre de ventas en clientes enterprise sube 41 %.

Retención de clientes del 96 % (porque nadie más ofrece este nivel de protección)

Mi recomendación de herramientas compliance

En un entorno cada vez más regulado y digitalizado, la adopción de herramientas de compliance no es opcional: es clave para asegurar que nuestras operaciones con datos y sistemas de IA cumplen con el RGPD, el AI Act y las buenas prácticas de gobernanza tecnológica.

He seleccionado estas herramientas que te van a permitir automatizar, auditar y controlar distintos aspectos críticos, reduciendo riesgos legales y reputacionales, y facilitando la transparencia y la confianza en tus campañas.

Cada tipo de herramienta cumple una finalidad específica dentro del ecosistema de cumplimiento:

- CMP: Usercentrics cookiebot (sin duda la mejor para Consent Mode v2). Garantiza que la recogida de consentimientos sea transparente y conforme a la normativa de cookies y privacidad. Además, es muy sencilla de implantar.

- Trazabilidad: Langfuse (gratis open source). Permite registrar y auditar cómo se usan los datos y modelos de IA, fundamental para cumplir con las obligaciones de documentación y rendición de cuentas.

- Guardrails: Lakera Gandalf o Guardrails AI. Estas herramientas establecen límites y controles técnicos para prevenir usos indebidos o resultados inesperados de la IA.

- Gobernanza: Holistic AI (la más completa enterprise). Esta herramienta me encanta porque centraliza la supervisión, la auditoría y la gestión de riesgos de los sistemas de IA y datos.

- Mapeo datos: DataGrail / Ethyca. Esta herramienta facilita conocer qué datos se recopilan, cómo se usan y dónde se almacenan, asegurando el cumplimiento de los derechos de los usuarios y de las obligaciones legales.

Checklist: Las 7 fases obligatorias antes de automatizar con IA

Resumo el Protocolo de Blindaje Legal y Estratégico que separa a las empresas que facturan más de las que asumen riesgos innecesarios. Puedes extraerlo y seguirlo paso a paso.

Fase 1: Clasificación del caso de uso

- Objetivo y Regla de Oro: Determinar el nivel de riesgo legal y de derechos del usuario (AI Act).

- Documentación Clave: Registro de casos de uso (Clasificación: Mínimo/Limitado/Alto).

Fase 2: Evaluación de datos y arquitectura

- Objetivo y Regla de Oro: Responder por escrito a las 7 preguntas clave (DPIA/minimización de datos) antes de usar cualquier dato.

- Documentación Clave: Tabla de 7 Preguntas (Trazabilidad, minimización, TIA, DPA).

Fase 3: Blindaje contractual (Legal Pack)

- Objetivo y Regla de Oro: Asegurar que los proveedores de IA tienen prohibido usar tus datos para entrenar y que asumen responsabilidad.

- Documentación Clave: DPA completo, Addendum específico IA, Model Card o System Card.

Fase 4: Transparencia obligatoria

- Objetivo y Regla de Oro: Informar de forma clara y visible al usuario que está interactuando con IA (YA es obligatorio por AI Act).

- Documentación Clave: Cláusulas de aviso en Chatbots y Emails, Watermark/Metadatos C2PA en imágenes.

Fase 5: Supervisión humana y safeguards

- Objetivo y Regla de Oro: Implementar la red de seguridad técnica para que la IA nunca actúe de forma descontrolada.

- Documentación Clave: Despliegue gradual (0.5% → 100%), Kill-switch (manual/automático), Logs de actividad (guardar huella 24 meses).

Fase 6: Evaluación Continua Trimestral

- Objetivo y Regla de Oro: Auditar el rendimiento y los sesgos del modelo de forma periódica para prevenir el drift.

- Documentación Clave: Informe ejecutivo trimestral, test de sesgos, revisión de 100 outputs aleatorios.

Fase 7: Gobernanza Interna de la empresa

- Objetivo y Regla de Oro: Convertir el cumplimiento en una máquina de generar margen y blindar la empresa desde dentro.

- Documentación Clave: Política Interna de Uso Responsable, Nombramiento de AI Officer, AI Responsibility Fee.

Conclusión: La IA no te va a sustituir… pero sí te puede arruinar si no hay gobernanza

El marketing ya no se define solo por la creatividad, el SEO o las campañas llamativas. Hoy, la verdadera ventaja competitiva está en la confianza, el cumplimiento, la seguridad y la trazabilidad.

Las empresas que integran la IA de forma seria, transparente y controlada:

- Aumentan márgenes sin asumir riesgos innecesarios.

- Compiten al nivel de grandes clientes enterprise.

- Previenen problemas legales y demandas costosas.

- Se consolidan como referentes del mercado, confiables y profesionales.

La diferencia real no está en usar la IA, sino en trabajar con garantías: contar con un marco sólido, replicable y rentable.

Quien lo implementa correctamente deja de ser “una empresa que usa IA” y pasa a ser “la empresa que protege al cliente mientras los demás provocan desastres”.

Porque en un mercado saturado de promesas vacías, la seguridad y la confianza son los activos que realmente generan valor duradero.