Escrito por Fernando Maciá

Índice

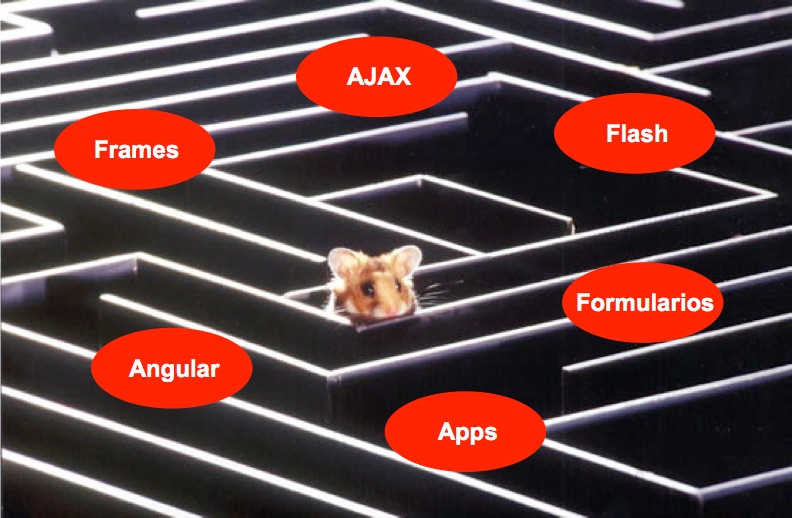

Qué es la indexabilidad

La indexabilidad de un sitio Web es la facilidad que tienen los buscadores de encontrarlo, rastrear sus contenidos e indexarlo. Un sitio Web es indexable cuando está enlazado, su contenido es accesible para los robots y resulta fácil clasificarlo en las categorías de búsqueda pertinentes.

Fases de la indexación de un sitio Web

Rastreo

Los buscadores cuentan en primer lugar con lo que se denomina un rastreador, reptante o robot. En el caso de Google, este robot se denomina Googlebot. Se trata de una especie de navegador que deambula por la Red intentando descubrir y rastrear la mayor cantidad de contenido posible.

Los robots de los buscadores utilizan principalmente los enlaces para descubrir nuevas páginas por lo que sólo con que encuentren un enlace apuntando a alguna página de un sitio Web, emplearán a continuación todos los enlaces disponibles en la misma para rastrear el resto de páginas que lo forman.

Aunque los enlaces son la principal forma en que los buscadores descubren nuevos contenidos, los gestores de sitios Web también pueden facilitar a los buscadores un “listado” completo de las páginas que desean indexar a través de un archivo sitemap. Se trata de un archivo en formato XML en el cual podemos incluir las páginas que deseamos que los robots indexen.

En general, los robots de los buscadores tratan de rastrear todas las páginas que encuentran enlazadas por lo que si no queremos que rastreen alguna página concreta deberemos indicárselo expresamente. Para ello podemos emplear instrucciones específicas en un archivo especial denominado robots.txt (en el que incluimos secciones de nuestra Web que no deseamos que los robots rastreen) o bien a través de una metaetiqueta denominada robots, en la cual podemos prohibir que los robots indexen un contenido determinado.

Cuando los robots descubren una nueva página, almacenan una versión de la misma en una memoria temporal del buscador denominada caché. La página queda identificada en el sistema de archivo del buscador mediante un identificador único: su dirección URL. Puede consultar la versión de cualquier página en la memoria caché del buscador simplemente anteponiendo la expresión “cache:” antes de su URL. Por ejemplo: “cache:http://www.elmundo.es/”.

Los robots de los buscadores visitan con frecuencia los sitios Web para mantener actualizados sus resultados y descubrir nuevos contenidos y más páginas. Estos robots dedican a esta tarea un tiempo limitado, de modo que si su servidor es lento o encuentra contenido erróneo, páginas inexistentes debido a enlaces rotos o contenido duplicado estará desperdiciando una gran parte del tiempo que el buscador podía dedicar a rastrear su sitio Web (crawl-budget).

Estas son algunas recomendaciones que facilitarán el rastreo de su sitio Web a los buscadores:

- Utilice código estándar HTML en sus páginas: evite gestores de contenido que hacen uso intensivo de funcionalidades JavaScript ya que los buscadores pueden no ejecutar este tipo de programación de una forma previsible y consistente.

- Asegúrese de que cada contenido cuenta con una única URL: es decir, no hay dos páginas distintas que se puedan visitar con la misma URL o dos páginas idénticas accesibles desde dos URLs distintas. Cada contenido debe contar con una URL única.

- Incluya un menú desde el que se enlaza a las páginas y secciones de contenido más importante de su sitio Web: no es conveniente que el menú incluya más de un nivel de enlaces desplegables. Y sí lo es enlazar directamente tanto a familias como a subfamilias de producto si su importancia así lo aconseja.

- Si en su sitio Web se emplea un buscador para navegar (como en un sitio Web de una inmobiliaria o un sitio Web de viajes) con preferencia a los enlaces del menú, asegúrese de desplegar un directorio que apunte a las páginas de resultados que desea que los buscadores puedan rastrear: los buscadores no pueden emplear formularios de búsqueda para descubrir, por ejemplo, su página de “pisos en Guadalajara” u “hoteles en Canarias” si no encuentran un enlace que apunte a esas páginas de listado.

- Sus productos más rentables, los servicios más demandados o los contenidos más leídos deberían estar a menos clicks de la página home: los buscadores rastrean con mayor frecuencia las páginas que se encuentran en los primeros niveles de la navegación. Por ejemplo, páginas enlazadas desde el menú o desde la propia página de inicio. Asegúrese de que sus páginas más importantes se encuentran cerca de la home y, proporcionalmente, cuentan con un mayor número de enlaces internos que el resto de páginas.

- Incluya contenido de texto enfocado, único y rico: preferiblemente que no aparezca en otros sitios Web pero tampoco en otras páginas de su propio sitio.

- Ofrezca contenido de texto complementario para aquellos contenidos que no son directamente rastreables, como imágenes o vídeos: a través del atributo alt de las etiquetas de imagen o del texto de subtitulado y los extractos en los vídeos.

- Asegúrese de que su servidor responde con rapidez a las solicitudes de descarga de páginas y que no registra caídas frecuentes: así facilitará que los buscadores puedan rastrear más páginas cada vez que lo visitan y no registrarán su sitio Web como un sitio de baja calidad por encontrar un número alto de errores de servidor.

Aunque estos son algunos de los puntos fundamentales, hay otros muchos que podemos optimizar para lograr un rastreo más frecuente y eficaz. El apartado enfocado a los aspectos relacionados con la indexabilidad en una auditoría SEO se enfocan a detectar posibles problemas u obstáculos que los buscadores podrían encontrar al rastrear un sitio Web. Tras establecer un diagnóstico, se indicarán las recomendaciones oportunas sobre el contenido, la programación o el propio servidor para garantizar que los buscadores pueden acceder de forma óptima a todo el contenido que consideramos importante para nuestro público objetivo.

Clasificación o análisis

Tras rastrear el sitio Web, el siguiente paso que llevan a cabo los buscadores consiste en analizar cada contenido para clasificarlo en categorías de búsquedas pertinentes o relacionadas. Es decir, el buscador debe responder a la pregunta: “¿Para qué búsquedas el contenido de esta página podría ser un resultado útil?”

Como es fácil suponer, para cada contenido nuevo que los buscadores encuentran y rastrean, ya existen otros contenidos similares previamente indexados que comparten clasificación con los recién descubiertos. Por ello el buscador debe decidir a continuación si el contenido rastreado debería ser añadido a su índice y en qué orden debería aparecer respecto al resto de contenidos de su misma categoría de búsqueda.

Para establecer las categorías de búsqueda pertinentes para un determinado contenido, los buscadores analizan todo el texto que encuentran en la página y se fijan especialmente en aquellas palabras y frases que se incluyen como títulos, encabezamientos, subsecciones, negritas, textos que actúan como enlace (anchor text). Son lo que denominamos áreas prominentes debido al hecho de que la presencia de ciertas palabras en ellas “pesan” más sobre la clasificación y ordenación de la página en los resultados que si las mismas palabras aparecen simplemente en un párrafo de texto.

Indexación propiamente dicha

Por lo general, los buscadores añadirán todas las páginas descubiertas de un sitio Web a su índice y clasificarán cada una de ellas en función de las búsquedas para las que consideran que son pertinentes. Pero hay algunos casos en que el buscador puede decidir no indexar una página que sí rastreó:

- Si un buscador detecta que muchas páginas de un mismo dominio se parecen mucho entre ellas, podría decidir no indexar todas ellas sino sólo las que considere más importantes. Esta situación en los que denominamos contenido duplicado y es importante evitar que se produzca en la medida de lo posible.

- Si un buscador detecta que muchas de las páginas rastreadas apenas cuentan con contenido y que éste es desproporcionadamente poco en relación con la publicidad, el buscador puede detectar estas páginas como contenido débil (thin content) por lo que tampoco las indexará.

Es importante conocer el número real de páginas de nuestro sitio Web para poderlo comparar con el número de páginas que los buscadores sí han indexado. La relación entre estos dos valores se denomina saturación y, por supuesto, queremos que esté tan cerca del 100% como sea posible.

Podemos hacernos una idea aproximada de las páginas que un buscador ha indexado en un determinado sitio Web haciendo una búsqueda con la expresión “site:dominio.ext” en Google. Por ejemplo, si buscamos “site:elmundo.es” Google nos dice que este dominio cuenta con aproximadamente unas 815.000 páginas indexadas.

Si somos los gestores de un sitio Web, podemos autenticarnos como tales en las herramientas de Google Search Console desde donde podemos acceder a datos muchos más precisos sobre el rastreo, clasificación e indexación de nuestro sitio.

Referencias adicionales

- Directrices de Google para Webmasters

- ¿Cómo funciona un buscador como Google? – Indexación

- ¿Cómo funciona un buscador como Google? – Relevancia

- Indexabilidad en Angular y React con Universal JavaScript

- ¿Cómo afecta JavaScript y AJAX a la indexación en Google?

- Cómo mejorar la indexación de un sitio Web en Google