Escrito por Fernando Maciá

Índice

Cómo analizar de forma eficiente la indexación y rastreabilidad de nuestro sitio web mediante Screaming Frog, Webmaster Tools (Aka Search Console) y Excel. Trabajaremos cómo, desde las auditoría inicial, preparar una migración compleja y el seguimiento constante de un site. Iñaki Huerta, Consultor de Marketing de Optimización en IKAUE.

Usamos ScreamingFrog porque es una herramienta totalmente orientada a SEO. También, porque esa forma de rastrear se parece a como trabaja el rastreador de Google. La forma básica de encontrar contenidos nuevos es similar: a través de enlaces. Evidentemente Google es mucho más potente. Pero nos ayuda a ver cómo podría indexar sólo con enlaces. Entendemos mejor lo que ve un robot en nuestra Web.

Otra ventaja: es muy barato. E incluso tiene una versión gratuita, eso sí, limitada a 500 URLs. En modo lista sí rastrea sin límite.

Por último, evoluciona constantemente y se intenta adaptar. Se integra con Google Search Console.

ScreamingFrog extrae mucha información en forma de tablas. No tiene una gran usabilidad, está hecha por técnicos, pero realmente es muy eficaz. Genera un informe de URLs internas y otro de externas, con todos los enlaces salientes.

Cuidado: a veces ScreamingFrog puede mostrar información de una forma inesperada. Por ejemplo, mezclando códigos de respuesta http de URLs propias y de enlaces externos.

¿Y qué hago con la rana?

Tres fases:

- Rastreo

- Recogida de criterios

- Análisis

ScremingFrog es muy bueno en los dos primeros puntos, no tanto en el tercero por el volumen de datos que maneja. Cuesta mucho trabajar en global sobre el site.

A la herramienta no se entra a mirar, se entra a responder preguntas concretas. De lo contrario, perdemos todo el tiempo.

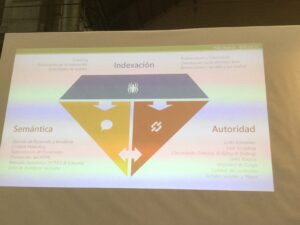

La indexación es el pilar básico. Después viene la semántica y la autoridad. Screaming nos ayuda sobre todo en el análisis de la indexación.

También nos ayuda en los otros dos, porque nos ayuda a auditar la semántica interna de los contenidos y nos habla de autoridad interna: enlaces internos a cada página.

Con ese esquema, tengo preguntas concretas que ScreamingFrog me ayuda a responder:

- Análisis técnico básico

- Auditoría onpage

- Análisis de estructura

- Control de migraciones

Análisis técnico

El lado más friki del SEO: las auditorías SEO técnicas. Lanzamos ScreamingFrog, nos vamos a tomar café y la herramienta nos extrae la información básica.

Tipología de archivos: problemas de carga, errores en archivos, etc. Permite identificar problemas básicos.

Problemas de codificación: UTF-8, ISO… Una Web correcta debe usar el mismo juego de caracteres en toda la Web.

Códigos de respuesta del servidor: 200 OK, redirect 301, errores 404…. Permite optimizar el tiempo de crawleo de las arañas. NO debe haber enlaces internos hacia redirecciones.

URL no deseadas: hay que hacerlo manualmente. URL que no tienen la forma esperada por meter la pata en el HTML. Trucos: busca «%», busca tu dominio dos veces, restos de HTML… Son cosas que pasan, y que pueden pasar inadvertidas.

Todo esto son las cagadas de los técnicos.

A partir de eso, objetivos: validar la orientación de la web hacia el posicionamiento deseado.

Anallizamos etiquetas principales, directrices de indexación, metadatos, duplilcidades, indexación real de URLs, páginas más importantes, conversión… Todo ello sincronizando con Google.

- Etiquetas principales que recoge: title, description, encabezamientos… Saca también el campo keywords que ya no se usa.

- Directivas de indexación que recoge: meta robots, canonical, next/prev… Que pueden causar algunos problemas graves cuando no se configuran correctamente. Cuidado con las cagadas en los canonical. Screaming lee el archivo robots.txt y podemos configurar para que lo respete.

- Análisis de titles (u otros tags): permite analizar titles duplicados, elementos que faltan (description, por ejemplo), titles demasiado largos o cortos, etc. No obstante, para seguimiento de etiquetas hay otras herramientas mejores: SEMRush, Sistrix, OnPage.org, etc. Pero sí es muy útil para hacer el análisis previo.

- Enlaces: permite identificar las páginas más importantes de mi site por número de enlaces entrantes, por tu propia arquitectura. Estas son las que más hay que cuidar, porque estamos concentrando en ellas más autoridad.

Extracciones de elementos

Además, podemos configurar para que extraiga cualquier elemento que me interese específicamente (Custom Extraction) enormemente interesante.

También podemos extraer tablas de etiquetas a nuestra medida. Deja algunas extracciones de ejemplo muy útiles.

DataLayer: muy potente para analistas Web.

El problema: ScreamingFrog baja al detalle de todo

Es fácil perderse en incidencias aisladas, en lugar de centrarse en los problemas centrales del sitio WEb. Cuál es la solución?: Excel. Exportamos y llevamos todo a Excel.

Exportamos el internal y el external y podemos analizar con tablas dinámicas y Excel y montarnos nuestro dashboard de indexación de un sitio Web.

Calidad de las URLs

Tu trabajo: datos de rastreo.

Análisis del buscador: cómo lo percibe Google.

Qué aporta a tu negocio: resultados del posciionamiento.

ScreamingFrog permite integrar Google Search Console dándole autorización desde nuestra cuenta de Google y a partir de ahí, los datos de Search Console se importan y añaden a cada URL. Es muy útil para ver cómo Google percibe esta indexación

Google Analytics: se concede autorización igual pero a la hora de importar datos es algo más complejo. Hay que definir qué datos quiero. Por defecto, SF extrae los básicos. Pero si tenemos Commerce configurado en Analytics, Screaming Frog permite añadir toda esa data a cada URL.

Añadimos los datos de Analytics y los tenemos integrados en cada URL. Es muy interesante. Así podemos priorizar mejor el trabajo.

Análisis de estructura y crawl budget

Google destina un tiempo de proceso a cada site, lo muestra en Estadísticas de rastreo en Google Search Console. Como no todo nuestro contenido es igual de importante a nivel de SEO, es importante evitar que Google pierda tiempo en páginas que no aportan valor. Si optimizamos ese proceso, Google mejorará la indexación del contenido interesante.

Podemos usar:

- WPO

- Link Sculpting

- Next/Prev

- Robots.txt

- Meta robots

- Canonicals

- Etc.

Así priorizamos la indexación de distintos contenidos para concentrar mi posicionamiento en ciertas URLs. Damos peso a unos u otros. Tengo que adaptar la arquitectura de la información a mi árbol de contenidos.

Los vemos en Site Structure de Screaming Frog: páginas que linkan a una página y nivel de URL (distancia en clicks desde la home). Todo ello me dice qué prioridad adjudico a una página en concreto.

También puedo extraer la ruta de rastreo de una página en concreto.

Migraciones en una Web

Las migraciones web son siempre un momento sensible porque te puedes cargar el tráfico de la Web. Screaming te permite controlar mucho más el proceso y comprobar que todo ha ido bien.

Partimos de la auditoría del nuevo site y, además, podemos validar los links de la antigua página respecto a la nueva.

Analizamos todo esto en un macro Excel, ponemos Screming en modo lista y así comprobamos todos los 301.